פרסומת

במהלך החודשים האחרונים יתכן שקראת את הסיקור סביב מאמר, מחבר משותף על ידי סטיבן הוקינג, לדון בסיכונים הכרוכים בבינה מלאכותית. המאמר הציע כי AI עשוי להוות סיכון רציני למין האנושי. הוקינג לא נמצא שם לבד - אילון מאסק ו פיטר ת'יל שניהם אנשי ציבור אינטלקטואליים שהביעו חששות דומים (ת'יל השקיע יותר מ -1.3 מיליון דולר לחקר הנושא ופתרונות אפשריים).

הסקירה של המאמר של הוקינג והערותיו של מאסק הייתה, שלא לשים עליו נקודה יותר מדי, קצת נעימה. הטון היה מאוד 'תסתכל על הדבר המוזר הזה שכל הגיקים האלה מודאגים ממנו.' התחשבות מועטה היא ברעיון שאם חלק מהאנשים החכמים ביותר בכדור הארץ מזהירים אותך שמשהו יכול להיות מסוכן מאוד, יכול להיות ששווה להקשיב.

זה מובן - בינה מלאכותית שמשתלטת על העולם בהחלט נשמעת מוזרה מאוד לא יתכן, אולי בגלל תשומת הלב העצומה שכבר הועברה לרעיון זה על ידי מדע בדיוני סופרים. אז מה כל אלה דיברו כל האנשים הרציונליים השפויים והרציונליים האלה?

מהי אינטליגנציה?

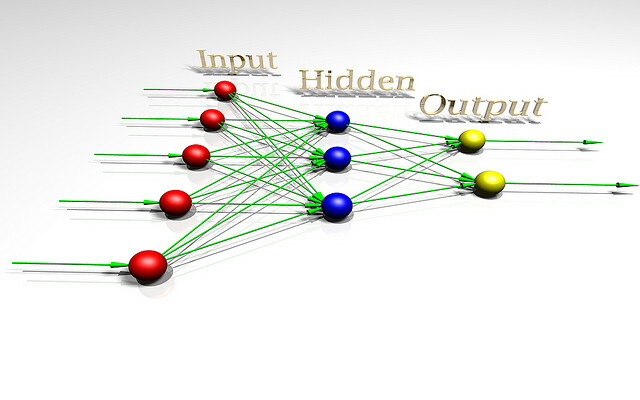

על מנת לדבר על הסכנה של בינה מלאכותית, יתכן שיעזור להבין מהי אינטליגנציה. בכדי להבין טוב יותר את הנושא, בואו נסתכל על ארכיטקטורת AI צעצועים המשמשים חוקרים החוקרים את תורת ההיגיון. צעצוע זה AI נקרא AIXI, ויש לו מספר תכונות שימושיות. המטרות יכולות להיות שרירותיות, הן משתנות היטב בכוח המחשוב, והעיצוב הפנימי שלה נקי וברור.

יתר על כן, תוכלו ליישם גרסאות פשוטות ופרקטיות של האדריכלות שיכולות לעשות דברים כמו שחק Pacman, אם אתה רוצה. AIXI הוא תוצר של חוקר AI בשם מרקוס הוטר, לטענתו, המומחה העיקרי בתחום הבינה האלגוריתמית. זה הוא מדבר בסרטון שלמעלה.

AIXI פשוט מפתיע: יש לו שלושה מרכיבי ליבה: לומד, מתכנן, ו פונקצית שירות.

- ה לומד לוקח חוטים של ביטים המתאימים לקלט על העולם החיצון, ומחפש באמצעות תוכנות מחשב עד שהוא ימצא כאלה שמייצרים את התצפיות שלו כפלט. תוכניות אלה, ביחד, מאפשרות לה לנחש כיצד ייראה העתיד, פשוט על ידי הפעלת כל אחת מהן תוכנית קדימה ומשקלול ההסתברות לתוצאה לאורכה של התוכנית (יישום של Occam's סכין גילוח).

- ה מתכנן מחפש בפעולות אפשריות שהסוכן יכול לבצע, ומשתמש במודול הלומד כדי לחזות מה היה קורה אם הוא ייקח כל אחת מהן. לאחר מכן הוא מדרג אותם לפי כמה טוב או רע התוצאות החזויות ובוחר את מהלך פעולה שממקסמת את הטוב של התוצאה הצפויה כפול ההסתברות הצפויה להשיג את זה.

- המודול האחרון, ה- פונקצית שירות, היא תוכנית פשוטה שלוקחת תיאור של מצב עתידי בעולם ומחשבת עבורו ציון כלי עזר. ציון השירות הזה הוא כמה טוב או רע התוצאה הזו ומשמש את המתכנן כדי להעריך את מצב העולם העתידי. פונקציית השירות יכולה להיות שרירותית.

- ביחד, שלושת המרכיבים הללו מהווים מייעל, שמיטוב למטרה מסוימת, ללא קשר לעולם בו הוא מוצא עצמו.

מודל פשוט זה מייצג הגדרה בסיסית לסוכן אינטליגנטי. הסוכן חוקר את סביבתו, בונה מודלים שלה ואז משתמש במודלים האלה כדי למצוא את דרך הפעולה שתמקסם את הסיכוי שהוא יקבל את מבוקשו. AIXI דומה במבנה ל- AI שמשחק שחמט, או משחקים אחרים עם חוקים ידועים - אלא שהוא מסוגל להסיק את כללי המשחק על ידי משחקו, החל מאפס ידע.

AIXI, שניתנה לו מספיק זמן לחישוב, יכול ללמוד לייעל כל מערכת למטרה כלשהי, מורכבת ככל שתהיה. זהו אלגוריתם אינטליגנטי בדרך כלל. שים לב שזה לא אותו הדבר כמו שיש אינטליגנציה דמוית אנוש (AI בהשראת ביולוגית הוא א נושא אחר לגמרי ג'ובאני אידיאלי מ- OpenWorm: מוח, תולעים ובינה מלאכותיתהדמיה של מוח אנושי היא דרך לדרך, אך פרויקט בקוד פתוח נוקט בצעדים ראשונים חיוניים, על ידי הדמיית הנוירולוגיה והפיזיולוגיה של אחת החיות הפשוטות ביותר המוכרות למדע. קרא עוד ). במילים אחרות, AIXI אולי תוכל להערים על כל בן אנוש בכל משימה אינטלקטואלית (בהינתן כוח מחשוב מספיק), אך יתכן שהוא לא מודע לניצחונה מכונות חשיבה: מה מדעי המוח והבינה המלאכותית יכולים ללמד אותנו על התודעההאם בניית מכונות ותוכנות אינטליגנטיות מלאכותיות יכולות ללמד אותנו על פעולות התודעה, ואופי המוח האנושי עצמו? קרא עוד .

בתור AI מעשי, ל- AIXI יש הרבה בעיות. ראשית, אין דרך למצוא את התוכניות שמפיקות את הפלט שהוא מעוניין בהן. זה אלגוריתם של כוח-ברוט, מה שאומר שזה לא מעשי אם אין לך מחשב עוצמתי שרירותי בסביבה. כל יישום בפועל של AIXI הוא בהכרח קירוב, ו (כיום) בדרך כלל יישום גס למדי. ובכל זאת, AIXI נותן לנו הצצה תיאורטית כיצד יכולה להראות אינטליגנציה מלאכותית חזקה, ואיך היא עשויה להסביר.

מרחב הערכים

אם עשית כל תכנות מחשבים היסודות של תכנות מחשבים 101 - משתנים וסוגי נתוניםלאחר שהצגתי ודיברתי מעט על תכנות מונחה עצמים לפני והיכן הדובדבן שלה מגיע, חשבתי שהגיע הזמן שנעבור את היסודות המוחלטים של תכנות באופן ספציפי שאינו שפה דרך. בית המלון מתפאר ב ... קרא עוד , אתה יודע שמחשבים הם מילולית, פדנטית ומילולית מכנית. המכונה לא יודעת או אכפת לה מה אתה רוצה שהיא תעשה: היא עושה רק את מה שנאמר לה. זוהי רעיון חשוב כשמדברים על בינה מכונה.

עם זה בחשבון, דמיין שהמצאת אינטליגנציה מלאכותית עוצמתית - הגעת עם אלגוריתמים חכמים ליצירת השערות התואמות את הנתונים שלך, וליצור מועמד טוב תוכניות. ה- AI שלך יכול לפתור בעיות כלליות, והוא יכול לעשות זאת ביעילות על חומרת מחשב מודרנית.

עכשיו הגיע הזמן לבחור פונקציית כלי שירות שתקבע מהם ערכי ה- AI. מה אתה צריך לבקש ממנו להעריך? זכרו, המכונה תהיה מילולית, מילולית פדנטית לגבי כל פונקציה שתבקשו ממנה למקסם, ולעולם לא תפסיק - אין בה רוח רפאים המכונה שתמיד 'תתעורר' ותחליט לשנות את פונקציית השירות שלה, ללא קשר לכמה שיפורי יעילות היא תעשה לשלה הנמקה.

אליעזר יודקובסקי במילים אחרות:

כמו בכל תכנות מחשבים, האתגר הבסיסי והקושי המהותי של AGI הוא שאם אנו כותבים את הקוד הלא נכון, ה- AI לא יסתכל אוטומטית על הקוד שלנו, לא יסמן את הטעויות, יגלה מה באמת התכוונו לומר ועשה זאת במקום זאת. אנשים שאינם מתכנתים מדמיינים לעיתים AGI, או תוכנות מחשב באופן כללי, כמקבילים למשרת שעוקב אחר הוראות ללא עוררין. אבל זה לא שה- AI הוא בהחלט צייתני לקוד שלה; אלא AI פשוט הוא הקוד.

אם אתה מנסה להפעיל מפעל ואתה אומר למכונה להעריך ניירות נייר ואז לתת לו שליטה על חבורה של רובוטים של מפעל, אתה עשוי לחזור למחרת ולגלות כי נגמר לו כל צורה אחרת של חומרי גלם, הרגה את כל העובדים שלך והכינה ניירות מהנייר שלהם נשאר. אם, בניסיון לתקן את הטעות שלך, אתה מתכנת מחדש את המכונה כך שהיא פשוט תשמח את כולם, אולי תחזור למחרת כדי למצוא אותה מכניסה חוטים למוחם של העמים.

העניין כאן הוא שלבני אדם יש הרבה ערכים מורכבים שאנו מניחים שמשותפים באופן מרומז עם מוחות אחרים. אנו מעריכים כסף, אך אנו מעריכים יותר חיי אדם. אנחנו רוצים להיות מאושרים, אבל לא בהכרח רוצים להכניס חוטים למוח שלנו כדי לעשות זאת. אנו לא חשים צורך להבהיר את הדברים האלה כשאנחנו נותנים הוראות לבני אדם אחרים. עם זאת, אינך יכול להניח הנחות מסוג זה כאשר אתה מעצב את פונקציית השירות של מכונה. הפתרונות הטובים ביותר תחת מתמטיקה חסרת נשמה של פונקציית כלי עזר פשוטה הם לרוב פתרונות שבני אדם היו מגדילים משום שהם מחרידים מוסרית.

מתן אפשרות למכונה אינטליגנטית למקסם את פונקציית השירות התמימה כמעט תמיד תהיה קטסטרופלית. כלשונו של הפילוסוף באוקספורד, ניק בוסטום,

איננו יכולים להניח שבאופן מוחלט כי אינטליגנציה-על תשתף בהכרח באף אחד מהערכים הסופיים הקשורים בצורה סטראוטיפית לחוכמה והתפתחות אינטלקטואלית בבני אדם - סקרנות מדעית, דאגה מיטיבה לאחרים, הארה רוחנית והתבוננות, ויתור על רכישות חומרית, טעם לתרבות מעודנת או לתענוגות הפשוטים בחיים, ענווה וחוסר אנוכיות, ו הלאה.

כדי להחמיר את המצב, קשה מאוד מאוד לציין את הרשימה המלאה והמפורטת של כל מה שאנשים מעריכים. יש הרבה היבטים בשאלה, ושכחתם של אחד מהם עלולה להיות קטסטרופלית. אפילו בקרב אלה שאנחנו מודעים אליהם, יש דקויות ומורכבות שמקשות על רישומם כמערכות נקיות של משוואות שנוכל לתת למכונה כפונקציית כלי עזר.

יש אנשים, שקוראים זאת, מסיקים כי בניית מכשירי ממשק משתמש עם פונקציות שירות זה רעיון נורא, ועלינו פשוט לתכנן אותם אחרת. הנה, יש גם חדשות רעות - אתה יכול להוכיח, רשמית, את זה כל סוכן שאין לו משהו שווה לפונקציה של כלי עזר אינו יכול לקבל העדפות קוהרנטיות לגבי העתיד.

שיפור עצמי רקורסיבי

פיתרון אחד לדילמה שלעיל הוא לא לתת לסוכני AI את האפשרות לפגוע באנשים: לתת להם רק את המשאבים שהם צריכים לפתור את הבעיה באופן שאתה מתכוון לפתור אותה, לפקח עליהם מקרוב ולהרחיק אותם מההזדמנויות להצליח לפגוע. לרוע המזל, היכולת שלנו לשלוט במכונות חכמות חשודה מאוד.

גם אם הם לא הרבה יותר חכמים מאיתנו, קיימת האפשרות שהמכונה "תתחיל רצועה" - לאסוף חומרה טובה יותר או לבצע שיפורים בקוד שלה עצמה שהופכת אותה לחכמה יותר. זה יכול לאפשר למכונה לזנק את האינטליגנציה האנושית לפי סדר גודל גדול, ולהערים על בני אדם באותה מובן שהאדם מעציף חתולים. תסריט זה הוצע לראשונה על ידי אדם בשם אני. י. גוד, שעבד על פרויקט ניתוח הקריפטים של אניגמה עם אלן טיורינג במהלך מלחמת העולם השנייה. הוא כינה זאת "פיצוץ מודיעין", ותיאר את העניין כך:

תנו למכונה אולטרה-אינטליגנטית להיות מוגדרת כמכונה שיכולה לעלות הרבה על כל הפעילויות האינטלקטואליות של כל אדם, פיקח ככל שיהיה. מכיוון שתכנון מכונות הוא אחת הפעילויות האינטלקטואליות הללו, מכונה אולטרה-אינטליגנטית יכולה לתכנן מכונות טובות עוד יותר; יהיה ללא ספק "פיצוץ מודיעיני", והאינטליגנציה של האדם תישאר הרחק מאחור. לפיכך, המכונה האולטרה-אינטליגנטית הראשונה היא ההמצאה האחרונה שאדם צריך אי פעם להכין, בתנאי שהמכונה מסודרת מספיק.

לא מובטח שפיצוץ מודיעיני אפשרי ביקום שלנו, אך נראה שהוא סביר. ככל שעובר הזמן, מחשבים מקבלים תובנות מהירות יותר ובסיסיות לגבי הצטברות אינטליגנציה. המשמעות היא שדרישת המשאבים לקפוץ אחרון אחרון למודיעין כללי ומגבשת צונחת ונמוכה. בשלב מסוים נמצא את עצמנו בעולם בו מיליוני אנשים יכולים לנסוע ל- Best Buy ולהרים את החומרה ו ספרות טכנית שהם צריכים לבנות אינטליגנציה מלאכותית המשפרת את עצמה, שכבר הקמנו עשויה להיות מאוד מסוכן. דמיין עולם שבו אתה יכול לעשות פצצות אטום מתוך מקלות וסלעים. זה סוג העתיד בו אנו דנים.

ואם מכונה אכן מצליחה לקפוץ, היא עלולה להתעלות במהירות רבה על המין האנושי מבחינת אינטלקטואל פרודוקטיביות, פתרון בעיות שמיליארד בני אדם לא יכולים לפתור, באותו אופן שבו בני אדם יכולים לפתור בעיות ש- מיליארד חתולים לא יכולים.

זה יכול לפתח רובוטים חזקים (או ביו או ננו-טכנולוגיה) ולקבל במהירות יחסית את היכולת לעצב מחדש את העולם ככל העולה על רוחו, והיינו יכולים לעשות מעט מאוד בנושא. אינטליגנציה כזו יכולה להפשיט את כדור הארץ ואת שאר מערכת השמש לחלקי חילוף ללא הרבה בעיות, בדרך לעשות כל מה שאמרנו לו. נראה כי התפתחות כזו תהיה קטסטרופלית עבור האנושות. בינה מלאכותית לא חייבת להיות זדונית כדי להרוס את העולם, רק אדישה קטסטרופלית.

כמו שאומר האמרה, "המכונה לא אוהבת או שונאת אותך, אבל את עשויה מאטומים שהיא יכולה להשתמש בהם לדברים אחרים."

הערכת סיכונים והפחתה

לכן, אם אנו מקבלים שעיצוב אינטליגנציה מלאכותית עוצמתית שממקסמת פונקציית שירות פשוטה היא גרועה, כמה צרות אנו באמת? כמה זמן עבר לנו עד שיתאפשר לבנות סוגים אלה של מכונות? קשה כמובן לדעת.

מפתחים בינה מלאכותית הם מתקדם. 7 אתרים מדהימים לראות את התוכנות האחרונות בתחום הבינה המלאכותיתבינה מלאכותית היא עדיין לא HAL משנת 2001: אודיסיאה בחלל... אבל אנחנו מתקרבים נורא. בטח, יום אחד זה יכול להיות דומה לאוכלוסיירים המדעיים המושטחים על ידי הוליווד ... קרא עוד המכונות שאנו בונים והבעיות שהם יכולים לפתור גדלו בהתמדה בהיקפן. בשנת 1997 כחול עמוק יכול היה לשחק שחמט ברמה גדולה יותר מאשר רב-סף אנושי. בשנת 2011, ווטסון של יבמ יכלה לקרוא ולסנתז מספיק מידע בצורה עמוקה ומהירה מספיק כדי לנצח את האדם הטוב ביותר שחקנים במשחק פתוח ותשובה פתוח עם משחקי מילים ומשחק מילים - זו התקדמות רבה בארבע עשרה שנים.

כרגע, גוגל כן השקעה רבה בחקר למידה עמוקה, טכניקה המאפשרת בניית רשתות עצביות עוצמתיות על ידי בניית שרשראות של רשתות עצביות פשוטות יותר. השקעה זו מאפשרת לה להתקדם ברצינות בזיהוי דיבור ותדמית. הרכישה האחרונה שלהם באזור היא סטארט-אפ Deep Learning בשם DeepMind, עבורו שילמו כ -400 מיליון דולר. כחלק מתנאי העסקה, גוגל הסכימה ליצור לוח אתיקה שיבטיח כי טכנולוגיית ה- AI שלהם תפותח בבטחה.

במקביל, IBM מפתחת את ווטסון 2.0 ו- 3.0, מערכות המסוגלות לעבד תמונות ווידיאו ולהתווכח כדי להגן על מסקנות. הם נתנו הדגמה פשוטה ומוקדמת של יכולתו של ווטסון לסנתז טיעונים בעד ונגד נושא בהדגמת הווידיאו שלהלן. התוצאות אינן מושלמות, אך צעד מרשים ללא קשר.

אף אחת מהטכנולוגיות הללו איננה מסוכנת ברגע זה: בינה מלאכותית כתחום עדיין נאבקת בהתאמה ליכולות ששולטו על ידי ילדים צעירים. תכנות מחשבים ועיצוב AI הוא מיומנות קוגניטיבית קשה מאוד, וככל הנראה תהיה המשימה האנושית האחרונה בה מכונות מתמחות. לפני שנגיע לנקודה הזו, יהיו לנו גם מכונות בכל מקום זה יכול לנהוג כך נגיע לעולם שמלא במכוניות נטולות נהגיםנהיגה היא משימה מייגעת, מסוכנת ותובענית. האם יום אחד זה יכול להיות אוטומטי על ידי טכנולוגיית המכוניות ללא הנהג של גוגל? קרא עוד , לעסוק ברפואה ומשפט, וכנראה גם דברים אחרים, עם השלכות כלכליות עמוקות.

הזמן שייקח לנו להגיע לנקודת הסיבוב של שיפור עצמי תלוי כמה מהר יש לנו רעיונות טובים. חיזוי ההתקדמות הטכנולוגית מסוגים אלו קשה לשמצה. זה לא נראה לא הגיוני שאולי נוכל לבנות AI חזק בעוד עשרים שנה, אבל זה גם לא נראה לא הגיוני שזה ייקח שמונים שנה. כך או כך, זה יקרה בסופו של דבר, ויש סיבה להאמין שכשזה יקרה, זה יהיה מסוכן ביותר.

אז אם נקבל שזו עומדת להיות בעיה, מה נוכל לעשות בקשר לזה? התשובה היא לוודא שהמכונות האינטליגנטיות הראשונות הן בטוחות, כך שתוכלו לאתחל את הרמה עד לרמה משמעותית של אינטליגנציה, ואז להגן עלינו מפני מכונות לא בטוחות שיוצרו אחר כך. 'בטיחות' זו מוגדרת על ידי שיתוף בערכים אנושיים, והיות מוכנה להגן ולעזור לאנושות.

מכיוון שאנחנו לא יכולים באמת לשבת ולתכנת ערכים אנושיים למכונה, כנראה שיהיה צורך לתכנן פונקציית כלי שירות המחייבת את המכונה התבונן בבני אדם, הסיק את הערכים שלנו ואז נסה למקסם אותם. על מנת להפוך את תהליך ההתפתחות הזה לבטוח, יכול להיות שימושי גם לפתח אינטליגנציות מלאכותיות שעוצבו במיוחד לא לקבל העדפות לגבי פונקציות השירות שלהם, ומאפשרות לנו לתקן אותם או לכבות אותם ללא התנגדות אם הם יתחילו להשתולל במהלך הפיתוח.

רבות מהבעיות שעלינו לפתור כדי לבנות אינטליגנציה מכונה בטוחה קשות מבחינה מתמטית, אך יש סיבה להאמין שניתן לפתור אותן. מספר ארגונים שונים עובדים בנושא, כולל הארגון עתיד מכון האנושות באוקספורד, וה מכון לחקר מודיעין מכונות (שפיטר תיל מממן).

MIRI מעוניין במיוחד בפיתוח המתמטיקה הדרושה לבניית AI ידידותי. אם יתברר כי ניתן לבצע אינטליגנציה מלאכותית על ידי אתחול, לפתח סוג זה של הטכנולוגיה של 'ידידותי AI' תחילה, אם תצליח, עשויה להיות בסופו של דבר להיות הדבר החשוב ביותר שיש לבני אדם אי פעם נעשה.

האם לדעתך בינה מלאכותית מסוכנת? האם אתה מודאג לגבי מה העתיד של AI עשוי להביא? שתף את מחשבותיך בקטע התגובות למטה!

קרדיט תמונה: Lwp Kommunikáció Via Flickr, "רשת נוירונים", על ידי fdecomite," img_7801", מאת סטיב ריינווטר," וולב אלקטרוני ", מאת קוני קברל,"new_20x", מאת רוברט קודמור,"מהדקי נייר“מאת קליפורד וואלאס

אנדר מוביל להישאר פונקציונלי עד 50 מעלות צלזיוס, סופר ועיתונאי שממוקם בדרום מערב. הוא אטום למים בעומק של מטר וחצי.